| MONOGRÁFICO: Redes Wifi |

|

|

|

| CAJON DE SASTRE - Cajon de sastre | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Écrit par Tomás Simal | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Samedi, 12 Février 2011 12:38 | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

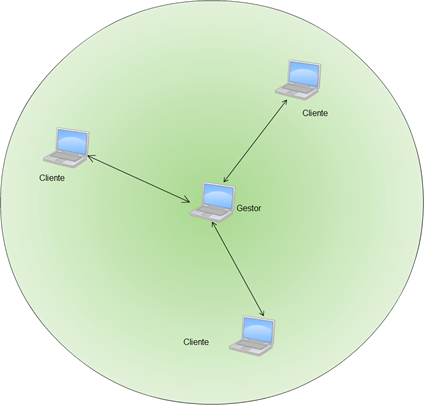

There are no translations available. Aunque la percepción general es que las redes inalámbricas son algo muy reciente, la realidad es que llevan existiendo y más de 15 años. Inicialmente no eran de uso general, si no que su utilidad se concentraba en mercados muy concretos, como la gestión de almacenes, educación y medicina (estos dos últimos con poca incidencia dentro de España en esa época). 1. Introducción1.1 Uso y utilidadNo fue hasta su estandarización, tras la creación de la “Wi-Fi Alliance” en 1996, organización que nació con la intención de verificar, certificar e impulsar sistemas con el protocolo 802.11, cuando estas redes empezaron a ser utilizadas por el público en general. El principal problema que existía hasta entonces era la falta de compatibilidad entre distintos fabricantes, pues aun cumpliendo todos ellos la norma 802.11, dicha norma dejaba abierta a la interpretación suficientes puntos como para hacer que sistemas de distintos fabricantes no trabajaran entre sí. Así pues la Wi-Fi Alliance permitió homogeneizar productos y hacer posible que se asentaran en el mercado de consumo, hasta el punto que hoy en día las redes inalámbricas se conocen popularmente por redes “Wi-Fi” en referencia a este organismo (termino que utilizaremos también en este documento para referirnos a ellas, aunque se hace notar al lector que existen redes de uso específico que no son “Wi-Fi”, las cuales no trataremos aquí). Desde su principio la idea de dichas redes fue substituir en la medida de lo posible las redes fijas, terminando así con los problemas inherentes al cableado como sus costes y la falta de movilidad. La situación a día de hoy no es tan perfecta como transmiten los diferentes fabricantes de esta tecnología y en la realidad mantienen su utilidad en aquellos entornos en los que la deslocalización o movilidad de los equipos es necesaria o el cableado es difícil o muy costoso. Sin embargo, a causa de la velocidad de transmisión, su naturaleza de medio compartido y problemas de transmisión, absorción, interferencias, etc. no posibilita que substituyan totalmente a las redes cableadas como algunos analistas llevan vaticinando, sin éxito, desde hace años. Una segunda utilidad que aún no siendo de uso masivo, si es muy interesante, es la opción de realizar enlaces inalámbricos entre distintas localizaciones. Así pues, es posible substituir con estos equipos enlaces punto a punto o punto multipunto que contratados a proveedores de telecomunicaciones serian costosos y de relativa baja velocidad, por otros de alta velocidad y coste muy bajo, con un retorno de inversión muy rápido. Sin embargo este tipo de enlace tiene limitaciones que no lo hace aplicable a todas las situaciones, pero aún así, no están siendo explotados todo lo que sería posible, normalmente por el desconocimiento de su existencia y características por parte de sus potenciales usuarios. 1.2 Arquitectura generalEn las redes Wi-Fi siempre existe, como estructura básica, un gestor de la comunicación y una serie de clientes. Los clientes, escucharán siempre para detectar la presencia de uno o más gestores que les indicará, entre otros datos, el nombre de la red que gestionan, el canal a usar, la seguridad y algoritmos de autentificación disponibles, etc.. En base a esta información y la configuración del dispositivo en cuestión, el cliente será capaz de unirse a la red adecuada. Dependiendo de quién implemente la función de gestión de la red, nos encontraremos ante una red “ad-hoc”, en la que el gestor es un ordenador integrante de la propia red, o una red de tipo “infraestructura” en la que el gestor en un punto de acceso, router o similar. En la práctica, una red ad-hoc solo la componen ordenadores, conformando una celda aislada (a no ser que uno de los ordenadores desarrolle funciones de bridge/router) y no tiene posibilidad de hacer unidad con otras celdas, mientras que una red del tipo “infraestructura” se integrará en la red cableada existente y permitirá crear varias celdas, que trabajarán conjuntamente, para dar una mayor cobertura espacial.

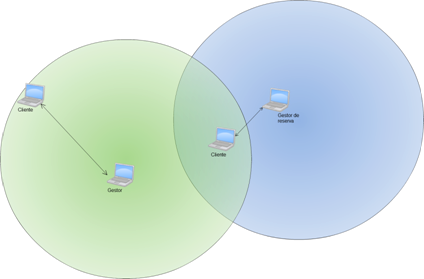

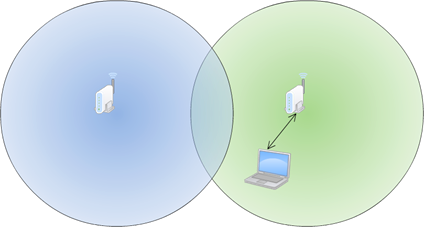

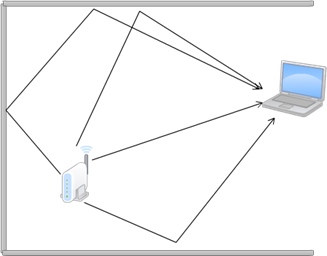

Red ad-hoc Es importante, como se ha indicado, conocer el funcionamiento de las redes Wi-Fi según el cual los clientes solo se conectan según las indicaciones del gestor de la celda, para prever y solucionar algunos problemas que pueden surgir estas redes. Por ejemplo, en las redes “ad-hoc” uno de los ordenadores realizará las funciones de gestor. Lo cual indica que dicho ordenador ha de estar siempre funcionando o la red desaparecerá con él. Así mismo su localización ha de ser tal que todos los demás miembros de esa red tengan visibilidad radio con él. Puede suceder incluso, que mas de un ordenador asuma el rol de gestor, bien por un error de configuración, o porque alguno está configurado de forma que cuando el gestor falla tome el control de la red, y en caso de que este gestor de reserva y el gestor activo no se detecten aparecerían dos gestores y por tanto dos redes, con clientes asociados a cada una de ellas dependiendo de la cercanía al gestor que controla la celda, y sin comunicación entre los dos grupos. En los siguientes esquemas se puede observar dicha situación. En la primera imagen se muestra una red en la que existe un gestor y un equipo que actúa de reserva, para asumir en el rol de gestor en caso de que el gestor principal desaparezca.

Si el gestor de reserva se desplaza de manera que no esté dentro del área de cobertura del gestor (o si el que se desplaza es el gestor, dejando sin cobertura al de reserva), el gestor de reserva asume el rol de gestor principal, al deducir que éste ha desaparecido y es necesario asumir las funciones de control de la celda. Es por esta razón que se producirá la ruptura de la celda en dos redes independientes, como se muestra en la siguiente ilustración.

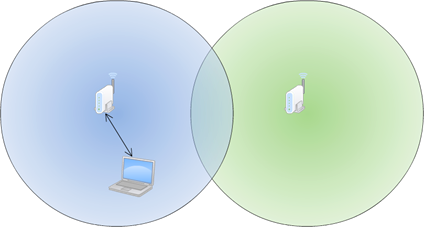

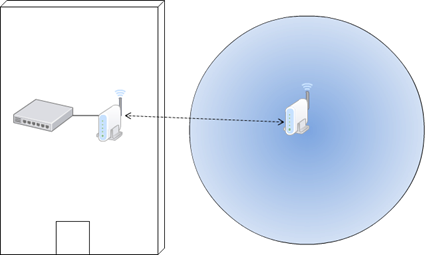

Sin embargo, las redes más habituales son las de tipo “infraestructura” y son las que analizaremos en este documento. En dichas redes, existe un dispositivo, normalmente un punto de acceso o un router (AP, abreviatura de “Access Point”, término ingles que es frecuentemente utilizado, y que lo será así mismo a lo largo del documento junto con otros términos en ingles, bien por ser el de uso habitual o por no existir traducción en nuestro idioma), que se encarga de la gestión de la red inalámbrica, enviando un paquete de información en el que indica el nombre de la red que conforma, métodos de autenticaciones soportados, canal a usar, etc. Con esta información lo clientes podrán solicitar el acceso y tras la autenticación necesaria serán miembros de la red y podrán trasmitir haciendo uso de esta. Para el envío de esta información se utiliza un tipo de trama especial que recibe el nombre de “beacon”. La trama de beacon es enviada periódicamente, permitiendo así a los equipos reconocer los distintos puntos de acceso existente, las redes disponibles, las potencias de recepción, los parámetros a utilizar en la organización de la transmisión de los diversos clientes, etc. El intervalo de emisión de esta trama es, en muchos equipos, configurable. Si se aumenta el intervalo se conseguirá una menor ocupación del ancho de banda disponible por tráfico de control de la celda y un mayor rendimiento de cara al usuario. Sin embargo la mejoría es muy escasa y en contra partida se producirá el efecto de que los clientes tardarán más en detectar la red, lo cual influirá en la velocidad de conexión a estas o en el tiempo necesario para llevar a cabo el proceso de “roaming” o cambio de celda, como se vera mas adelante. Cada AP conforma una celda, es decir, el área que da cobertura, a donde llega su emisión con la potencia necesaria para ser recibida por los clientes. Sin embargo este área puede no ser suficiente. La normativa implica que no puede emitirse una potencia superior a 100mW lo cual limita el alcance, que suele ser en el mejor de los casos de 300m de diámetro en campo abierto, y 150 en entornos de oficinas, pero con grandes variaciones dependiendo de la norma Wi-Fi del aparato y su calidad, el entorno, materiales, equipos utilizados, etc. lo que conduce a que típicamente los alcances en interior suelen estar más en el orden de 60 metros de diámetro por los distintos materiales y elementos (sobre todo metálicos y electrónicos) que suelen estar presentes en este tipo de entorno. Ante la necesidad de cubrir mayores aéreas se prevé la posibilidad de utilizar más puntos de acceso de manera que la suma de las celdas que cada uno de éstos conforman, cubra toda la superficie que se desea cubrir. Esta configuración permite que un cliente se conecte a uno u otro punto de acceso dependiendo cuál de ellos proporcione una mejor calidad de recepción, con lo que el cliente podrá moverse libremente por todo el área de cobertura y el enlace físico pasara de una celda a otra según sea necesario (función conocida con el término “roaming”). En las siguientes imágenes se muestra el proceso de roaming de un dispositivo que se desplaza de la zona de cobertura de una celda a la contigua. En la primera imagen, el equipo se encuentra en la celda azul, con una buena cobertura y sin detectar ninguna otra celda, con lo que la asociación se realiza con el punto de acceso que genera dicha celda.

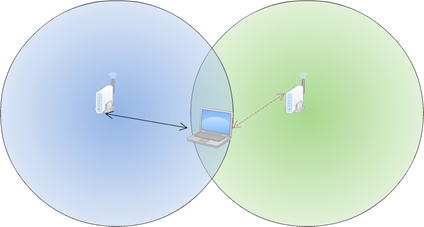

Al desplazarse, el cliente Wi-Fi entra en la zona en la cual se solapan ambas celdas. Empezará a detectar las tramas beacon enviadas por el punto de acceso de la segunda celda y tras comprobar que se trata de la misma red y que se posee la acreditación necesaria (por ejemplo la clave correcta), empezará a evaluar la calidad de recepción de esta celda, monitorizando ambas señales.

al continuar el desplazamiento, llegará un punto en que la calidad de recepción de la celda verde sea mejor que la de la celda azul, con lo que se asociará al nuevo punto de acceso que conforma la celda verde y cancelará la asociación del punto de acceso que genera la celda azul.

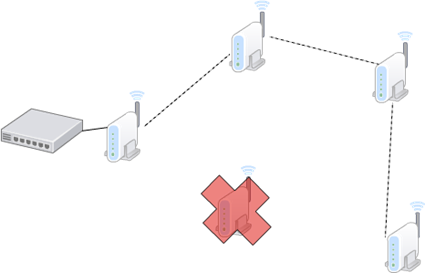

Este cambio suele ser rápido para la mayoría de los propósitos, pero depende de los terminales y los puntos de acceso. Así mismo en algunos casos es posible configurar el modo de funcionamiento del proceso de roaming, primando la permanencia en la celda actual o el cambio rápido a una celda con mejor recepción. Es obvio que la segunda opción permitirá que el cliente este siempre asociado al mejor punto de acceso, por lo que se conseguirán mejores rendimientos, pero tiene el peligro de que si se mueve por el limite de las celdas, puede estar cambiando constantemente de celda, causando una gran carga en los equipos, que estarán un porcentaje del tiempo significativo realizando la función de roaming en vez de transmitir los datos, ralentizando la comunicación y logrando por tanto el efecto contrario al deseado, Al colocar varios puntos de acceso para dar cobertura a un área mayor que el de la celda individual, hay que tener en cuenta que dichas áreas se solapen ligeramente, para que los clientes tengan un espacio en el que hacer el cambio de una celda a otra sin perder conectividad. Se debe tener en cuanta así mismo que todos los puntos de acceso han de tener una configuración coherente en cuanto a nombre de red y sistemas de autenticación. A cerca de las frecuencias se intentará no repetirlas entre celdas que solapen, distanciando las frecuencias tanto como sea posible para evitar interferencia entre ambas celdas, pues en caso de no hacerlo, la influencia entre estas influiría en un menor ancho de banda disponible para los clientes. Existe una estructura, variante del tipo “infraestructura” que se conoce habitualmente como red en malla o mas habitualmente por su termino inglés “mesh”. En esta estructura existirán puntos de acceso que no tiene conexión a la red cableada. Éstos crearán un enlace inalámbrico con alguno de aquellos que sí tengan conexión a la red fija, y a su vez creará una celda local que dará cobertura a los clientes de la zona. Esto por si solo no sería más que una extensión inalámbrica, pero en una red mesh se permite la existencia de varios niveles. Para alcanzar puntos lejanos es posible que un punto de acceso se conecte con otro punto de acceso, y así sucesivamente en tantos niveles como sean necesarios o como permitan los equipos utilizados, hasta que a su vez se cree un enlace con aquel que tiene conexión con la red cableada. Esto ofrece la posibilidad de crear áreas de cobertura Wi-Fi en zonas que no tienen posibilidad de conectarse a una red de datos cableada, aunque sea una zona lejana y sean necesarios varios saltos. Así mismo, en los sistemas avanzados, se posibilita que los enlaces entre los puntos de acceso se reconfiguren en el caso de que un fallo en alguno de los equipos o un elemento externo impida el funcionamiento de alguno de los enlaces preconfigurados. En el gráfico siguiente se muestra un ejemplo de red tipo mesh.

En ella se observa como solo un punto de acceso tiene conexión a la red cableada, mientras que el resto mantiene enlaces inalámbricos para acceder a la red fija, en algunos casos mediante varios saltos. En el caso de que uno de los puntos de acceso presentara un fallo, la red podría reconfigurarse, en el caso de algunos sistemas de manera automática, para permitir seguir dando servicio a los usuarios, tal como se muestra en el gráfico siguiente, en el que se muestra la red anterior, en la que un punto de acceso dejado de funcionar:

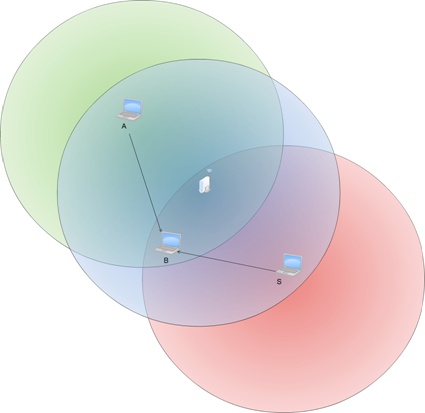

Existen herramientas que posibilitan la configuración automática y coherente de los puntos de acceso, así como funcionalidades avanzadas de las que hablaremos en un punto posterior. Es importante tener en cuenta que todos los puntos de acceso que conforman una red, han de estar conectados al mismo segmento lógico de red cableada. Hay dos puntos que fuerzan a que así sea; uno es que resulta habitual que los puntos de acceso tengan que comunicarse entre ellos por la red cableada para gestionar el roaming, y otro es que el cliente sale a la red cableada a través del punto de acceso que conforma la celda en la que está en ese momento. Esto hace que el cliente, debido a sus cambios de celda, entre a la red por diferentes puntos, pero manteniendo las mismas direcciones IP y MAC. Si dos puntos de acceso estuvieran en subredes diferentes, la dirección IP del cliente dejaría de ser válida al cambiar de celda/AP (que equivaldría a cambiar de subred), además podría dar problemas en firewalls, configuraciones de listas de acceso en switches, etc. que habrá que tener en cuenta a la hora de diseñar la red. Una solución a este problema seria la utilización de un controlador con funciones de tunelización como se verá en un apartado posterior. En general, la constitución básica de una red inalámbrica, consta de tres parámetros principales: el nombre de la red, los canales utilizados y la seguridad implementada. Cada red se definirá mediante un nombre, denominado SSID, que es un identificador alfanumérico que designa la red. Todos aquellos puntos de accesos que conformen una red deberán compartir el mismo SSID. El cliente cuando busca las redes existentes, las reconoce por el nombre que estas publican. Sin embargo es posible que una red no publique el nombre. Este funcionamiento es una medida que se puede adoptar como estrategia de seguridad, en cuyo caso, para conectarse a esa red, habrá que conocer su nombre y será necesario configurarlo manualmente en el cliente. En cada punto de acceso se indicará cual es el canal que se utilizará. El cliente que desee conectarse a la celda deberá utilizar el canal indicado. Así pues, no es el cliente, si no el punto de acceso (o en el caso de redes ad-hoc, el equipo que toma el rol de gestor de la celda), el que fija el canal a utilizar. Aunque dos o mas equipos coincidan en el mismo canal, será posible diferenciarlos por el nombre de red asignado a cada uno de ellos. En caso de tener el mismo SSID y por tanto pertenecer a la misma red será el cliente el que elegirá a cual conectarse dependiendo de la calidad de recepción (o forzará la conexión el punto de acceso en caso de existir listas de acceso que fuercen al cliente la elección de uno de ellos mediante la denegación del permiso de conexión a los demás). Tras tener el cliente conocimiento de la red a la cual desea pertenecer, los puntos de acceso que pertenecen a ella y que están a su alcance para conectarse, en base a la calidad de recepción elegirá uno de dichos puntos de acceso y fijará su canal en el que este le indique. Para proceder a la conexión deberá cumplir con los requisitos de seguridad que le imponga la red y que le serán indicados por el punto de acceso. Será imprescindible que todos los puntos de acceso que pertenezcan a la misma red (es decir, que tengan el mismo SSID), implementen los mismos requisitos de identificación y autentificación de los usuarios. Lo más habitual es realizar dicha autentificación mediante una clave compartida, que deberá ser conocida por el cliente y compartida por todos los puntos de acceso que integran la red, aunque no es el único método como veremos en puntos posteriores. Así mismo el método de autentificación deberá ser común y soportado por todas las partes. Como se ha comentado brevemente con anterioridad, existen varias frecuencias/canales en las que funcionan estos sistemas. Actualmente hay distintas variedades de redes Wi-Fi, descritas cada una por su propia norma. Cada una de estas normas se sitúa en uno banda de frecuencias disponibles para este uso (excepto la 802.11n que puede funcionar en ambas frecuencias): la banda de 2,4 GHz y la de 5 GHz. La banda más ampliamente utilizada es la de 2,4GHz, por distintos motivos, como el menor coste de los dispositivos, la más temprana utilización de esta banda,… pero principalmente, en Europa, y en particular en España, por regulaciones del espectro radioeléctrico. La banda de 2,4 GHz fue de uso libre no regulado ya cuando las redes inalámbricas surgieron, pero la banda de 5 GHz no se liberó hasta más adelante, cuando las redes Wi-Fi ya estaban en uso, por tener un uso gubernamental en España. Actualmente ambas frecuencias son de libre uso, lo cual permite la utilización de dispositivos Wi-Fi que hagan uso de ellas. Dentro de cada una de esas banda de frecuencia, existe una división en canales que permite posicionar las distintas redes o celdas que coinciden en un mismo área, en diferentes frecuencias para facilitar un funcionamiento más ordenado y evitar, en la medida de lo posible, las colisiones, interferencias, etc. 2 Consideraciones generalesLas redes Wi-Fi son redes inalámbricas, por tanto redes vía radio, con todo lo que ello implica respecto a frecuencias, interferencias, influencia del entorno, etc. Esto nos obliga a recapacitar sobre las implicaciones que ello tiene, tanto en la manera de funcionar como en las limitaciones y problemas que de ello pueden surgir. La primera consecuencia de esto es que los clientes no están claramente definidos, ni en número, ni en situación, lo cual provoca la necesidad de una gestión de éstos. Será necesario autentificarlos, notificarles parámetros de funcionamiento como el canal a utilizar, etc. Así mismo al ser un medio compartido (aquí cada cliente comparte el aire, no tiene un cable independiente cada uno) es necesario tener un mecanismo que ordene su funcionamiento y acceso al medio, para evitar en lo posible las colisiones, situación en que uno o más equipos transmiten a la vez, interfiriéndose entre ellos e invalidando la comunicación, y en el caso de que éstas sucedan, proveer los mecanismos para solventar la incidencia. Todo ello es realizado de forma transparente para el usuario, pero tiene un coste total: una reducción de la velocidad de transmisión. Para el control de la transmisión se utilizan dos protocolos complementarios: CSMA/CA y RTS/CTS. El mecanismo definido en el CSMA/CA es una adaptación del CSMA/CD utilizado en las redes Ethernet, pero modificado para tener en cuenta la limitación de las comunicaciones por radiofrecuencia según la cual una estación transmitiendo no puede detectar una colisión con otra transmisión simultánea. El algoritmo dicta que un equipo que desea transmitir, antes de hacerlo ha de escuchar para comprobar si ya existe otra estación enviando datos. En caso de no ser así podrá transmitir, pero si ya hubiera algún equipo transmitiendo deberá esperar un tiempo aleatorio y transcurrido este, volver a comprobar si el medio esta ocupado por otra transmisión. Este algoritmo presenta varios problemas. Uno es que existe la posibilidad de que dos o mas equipos comprueben a la vez si se esta transmitiendo y al detectar que el canal esta libre, empiecen a emitir de forma simultanea. Este problema deberá ser solucionado por protocolos superiores como TCP que se encargarán de detectar pérdidas de información y pedir la retransmisión de esta. Así mismo, al ser el tiempo de espera, cuando se detecta el canal ocupado, tomado de forma aleatoria se consigue paliar en parte el problema de la concurrencia de equipos al comprobar el uso del canal. Otro es el problema conocido como “terminal oculto”, que se muestra en la siguiente ilustración.

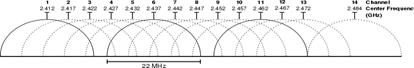

Este problema se produce cuando, estando los terminales “A”, “B” y “S” en la misma celda, cuya cobertura esta mostrada en azul, un terminal “A” tiene visibilidad de otro terminal “B” pero no de un terminal “S”, como se ve por su área de cobertura mostrada en verde. Un caso típico en el que puede pasar esto es que se encuentren en fila por lo que la distancia de “A” a “B” sea relativamente corta, pero la de “A” a “S” suficientemente larga como para que no se detecten, pero sin embargo “B” al estar a mitad de camino si tenga recepción de “S”, cuya área de cobertura se muestra en rojo. Esta situación también puede suceder por elementos arquitectónicos que impidan la visibilidad entre “A” y “S”, pero si permitan la comunicación entre “S” y “B” y entre “A” y “B”. En esta situación el terminal “S” puede emitir para enviar información a “B”. Si el terminal “A” así mismo quisiera transmitir, escucharía el canal, y al no tener visibilidad de “S” encontrará el canal vacío y transmitirá. El problema surge del hecho de que “B” sí tiene visibilidad de ambos terminales, así que detectará ambas señales de forma simultánea, que interferirán y harán la comunicación inválida, y lo peor es que ni “A” ni “S” tendrán constancia del problema, así que la situación puede dilatarse en el tiempo indefinidamente. Para solventar este problema, así como alguno más (por ejemplo la iteración entre clientes 802.11b y 802.11g) se implementó en estas redes Wi-Fi el protocolo RTS/CTS. Es obligatorio para los equipos tener implementado este protocolo, pero no lo es tenerlo activado, aunque por defecto suele estar activo para evitar problemas como el del terminal oculto. Cuando el protocolo RTS/CTS esta activado, se añade al CSMA/CA, de manera que una vez que el terminal que ha detectado que nadie está transmitiendo, enviará una trama RTS al terminal destino, indicándole que desea transmitir y, entre otros datos, cuanto tiempo (en bytes) durará esa transmisión. Si en terminal destino está en condiciones de recibir la información, responderá con una trama CTS repitiendo así mismo la información que indica cuanto tiempo durará la transmisión. Con este intercambio, se consigue que el canal quede reservado y los demás equipos sepan que han de esperar al menos el tiempo que se indica en las tramas RTS y CTS para poder transmitir ellos, y puesto que tanto emisor como receptor transmiten la información, todos aquellos sistemas que pudieran interferir con esa transmisión recibirán la trama RTS, la CTS o ambas. Es un error común y fuente de problemas suponer que la velocidad de transmisión que publicita una norma o un producto es la real que alcanzaremos, tal como sucede en el caso de las redes cableadas, si los equipos implicados no presentan alguna limitación de diseño. No es así en el caso de las redes inalámbricas, pues la gestión de la comunicación, mayormente por el control de usuarios y los mecanismos de organización de la transmisión descritos anteriormente, implica que la velocidad de transmisión (ancho de banda) disponible para el usuario ronda el 50% de la velocidad máxima de la red. Esta situación será la ideal, y el rendimiento puede ser incluso menor por limitaciones de los equipos implicados (tanto APs como clientes). Añadido a ello, aunque los equipos implicados sean capaces de proporcionar la máxima velocidad, hay otros factores como interferencias, reflexiones, etc. que influirán en el rendimiento. Aún siendo el medio ideal, la distancia también influirá en el rendimiento. Dentro del mecanismo de funcionamiento de las redes Wi-Fi se prevé que cuando la potencia baje o el ruido o interferencias aumenten, el cliente sincronizará a una velocidad menor, de manera que el mecanismo de transmisión para esa menor velocidad proporcione mayor inmunidad ante la degradación de la señal. La distancia es uno de esos factores que disminuyen la potencia de la señal, así que dentro de la celda, la velocidad disponible para los clientes disminuye con la distancia, creándose áreas con velocidades decrecientes según sea mayor la distancia al punto de acceso. En lo sucesivo, al indicar las diferentes velocidades alcanzables según las diferentes normas, se suministra el valor de la máxima velocidad de transmisión alcanzable por los sistemas que a dicha norma se ajusten, que será mayor a la disponible por el usuario tal como se acaba de explicar. Es necesario considerara así mismo las frecuencias concretas que utilizan los quipos Wi-Fi. Como se comentó en el punto anterior, las redes actuales pueden utilizar las bandas de 2,4 GHz o 5 GHz. *Gráfico creado por Michael Gauthier, publicado en Wikimedia Commons, bajo licencia Creative Commons Attribution-Share Alike 2.0 Unported Como se puede apreciar en la gráfica anterior existe un fuerte solapamiento entre canales, quedando resumido éste en la siguiente tabla.

Recientemente se aprobó una nueva norma, la 802.11n, que permite mayores velocidades de transmisión y puede funcionar en la banda de 2,4 GHz. Es importante conocer que los equipos que funcionan bajo esta norma, consiguen esta mayor velocidad gracias al uso, entre otras estrategias, de canales con un ancho de 40 MHz. El uso de este ancho de banda implica la utilización de dos canales no solapados, como podía ser el 1 y el 6. Por la tabla anterior, vemos que solo quedaría libre sin solapamiento los canales 11 a 13, lo cual podría acomodar sin comparición de frecuencias, algún canal 802.11b o 802.11g pero no otro canal 802.11n. Esto implica que no hay espacio en la banda de 2,4 GHz para acomodar dos canales de 802.11n que no se solapen. La consecuencia de esta circunstancia será que la existencia de dos o más equipos 802.11n provocará que parte o la totalidad de su canal solape, y por tanto genere y reciba interferencia de los otros equipos, reduciendo el ancho de banda. Así mismo la convivencia de estos equipos con otros Wi-Fi de normas anteriores que funcionen en la misma banda, será compleja, puesto que quedarán pocos canales libres sin solapamiento. Esto no quiere decir que no puedan funcionar conjuntamente, si no que interferirían entre ellos en cuanto exista solapamiento y el rendimiento de la red se reducirá. En la banda de 2,4 GHz aparece otra circunstancia particular. El lector podrá comprobar que su microondas tiene una frecuencia de trabajo situada en la misma banda de frecuencias (con ligeras variaciones). Esto indica claramente que la frecuencia utilizada por las redes Wi-Fi de esta banda está en la el rango de la resonancia de las moléculas de agua y, tal como ocurre con las generadas por el magnetrón del microondas, será absorbida por todo objeto que contenga este elemento. Así pues, como norma la señal será fuertemente absorbida por elementos como agua, madera, cartón, plantas, personas o animales, etc. en general, todo aquello que se caliente en un microondas. Esta es una de las razones por las que existe una normativa tan fuerte en la potencia de emisión (100mW), la cual pretende evitar causar daños a los organismos vivos. La otra razón de esta limitación es controlar el alcance de estos sistemas, ya que es una banda de uso libre, con una reducida potencia máxima de emisión se minimizan las interferencias y se permite la convivencia con otros sistemas existentes. Otro problema de la banda de 2,4 GHz es que existen multitud de sistemas que emiten en esta banda: teléfonos inalámbricos, dispositivos bluetooth, centrales de alarma inalámbricas, microondas, ratones y cascos inalámbricos, etc. los cuales generan interferencias que reducirán el rendimiento de la comunicación. Se trata de una banda muy saturada, que por su temprana liberalización, ha sido profusamente utilizada por multitud de equipos La banda de 5GHz fue liberalizada con posterioridad a la de 2,4GHz y aparecieron normas que hacen uso de ella; la 802.11a y, recientemente, la 802.11n. La banda de 5 GHz ofrece 24 canales no solapados entre sí (aunque con diferencias entre países debido a la normativa diferente en cada región), lo cual es una gran ventaja sobre la banda de 2,4 GHz en la que solo existen tres canales sin solapamiento. Esto permite que sea más fácil evitar las interferencias entre equipos, pues es muy probable la existencia de un canal libre que nos permita la configuración del equipo sin entrar en conflicto con sus vecinos. Añadido al mayor número de canales disponibles, el menor número de equipos electrónicos existentes que usan esta banda, comparativamente con la banda de los 2,4 GHz, hace que las interferencias sean potencialmente menores, y los puntos de acceso Wi-Fi que operen en esta frecuencia tendrán menos señales compitiendo por la misma porción del espectro. Sin embargo, la banda de 5 GHz tiene problemas que hacen que su implantación sea mucho menor que la de 2,4 GHz. Por un lado la menor oferta de sistemas que hacen uso de esta banda, lo cual reduce la posibilidad de elección. Por otro lado, el peso del parque de equipos instalados, a los que normalmente se desea seguir dando servicio, y que, en la mayoría de los casos, sería extremadamente costoso substituir. Otro factor es el mayor coste los equipos de 5GHz. Aunque los procesos de fabricación se han ido abaratando, los equipos de radiofrecuencia son, como norma general, más costosos cuanto mayor es la frecuencia a la que trabajan. El consumo así mismo es mayor para equipos que trabajen a frecuencias más altas, lo cual influye en los equipos móviles negativamente, en los que la duración de la batería suele ser un dato crucial, y aunque la diferencia no sea objetivamente significativa, si puede ser decisiva desde el punto de vista publicitario y percepción por el usuario. Por último, la propagación radioeléctrica es más costosa cuanto mayor es la frecuencia, pues la absorción de la señal por el medio se incrementa, lo cual tiene como consecuencia un mayor consumo para un igual alcance, y en la práctica un menor alcance de ésta banda, en campo abierto, comparado con la de 2,4 GHz. Este último punto es matizado en muchas ocasiones, pues la banda de 5 GHz no presenta la absorción por parte del agua, que sí afecta a la de 2,4 GHz. Así pues en entornos húmedos, lluvia, niebla, arboles, cartón, etc. la absorción será menor y su comportamiento mejor que con la banda de 2,4 GHz. En un futuro cercano, se prevé que la banda de 5 GHz tome mucha más relevancia debido a las ventajas antes expuestas, y sobre todo a la implantación de 802.11n que hará que el uso de esta banda sea mucho más positivo mostrando claramente sus ventajas. Una característica general, que afecta a todas las transmisiones inalámbricas, es la reflexión de las ondas. Cualquier elemento metálico actuará como un espejo a las ondas, lo cual tendrá un doble efecto: bloqueará la transmisión y producirá un reflejo. El bloqueo de la señal deberá ser tenido en cuenta pues podrá crear áreas sin cobertura, y por tanto sin acceso a la red Wi-Fi. Es un efecto fácil de ver y evaluar, aunque en muchas ocasiones no tan fácil de solventar. La reflexión de señal es un efecto un tanto más complejo de evaluar y solventar. Los puntos de acceso habitualmente emiten omnidireccionalmente, con una cierta polarización en alguno de los sentidos, pero a no ser que estén destinados a algún uso específico (como la unión de edificios, en cuyo caso lo habitual es utilizar antenas direccionales con una mayor ganancia de señal) es deseable que la cobertura sea homogénea en todas direcciones lo cual provoca que el diseño de antenas se realice para que irradien igual en cualquier dirección. La señal, por tanto, se propagara en dirección al cliente, pero así mismo en el resto de direcciones. Si en esas otras direcciones se encuentra con un material que no sea absorbente, si no que refleje la señal, puede resultar que al cliente le llegue una nueva señal producto de esa reflexión. El problema de dicha señal reflejada es que el camino recorrido no será igual en longitud y por tanto llegara con un cierto retraso con respecto a la señal directa y con un retraso o adelanto con respecto a otras señales reflejadas. El cliente detectara una señal que será la suma de las diversas señales que le llegan, tanto directas como reflejadas. Al estar estas retrasadas unas respecto a las otras, detectará una onda con una forma potencialmente muy diferente a la original. Se ve por tanto que las señales reflejadas se comportan como interferencias influyendo negativamente en el funcionamiento de la red inalámbrica.

El efecto de recibir varias señales, causado por la suma de la señal directa mas las reflejadas se denomina con el termino ingles “multipath” y es un problema común a toda comunicación por radiofrecuencia, pero que el caso de redes Wi-Fi es mas notorio dado que habitualmente son redes que se desarrollan en entornos de interior donde existen gran cantidad de obstáculos tanto arquitectónico como objetos que pueden provocar estas reflexiones. Con el objeto de evitar este problema la acción más inmediata es buscar una nueva ubicación para el punto de acceso, pues es su situación espacial la que determinara los distintos reflejos y caminos que puede tomar la señal. No hay un método teórico para elegir la ubicación del punto de acceso, puesto que el cálculo de los diferentes caminos es inviable en la práctica y deberá hacerse de forma empírica mediante el proceso de prueba y error, ayudado de alguna herramienta de las que hablaremos en apartados posteriores. Un sistema que se ha popularizado en los últimos tiempos, y más aun tras la adopción de la norma 802.11n que lo contempla como parte de la norma, es la inclusión de sistemas M.I.M.O. (Multiple Input Multiple Output, o, traducido libremente, sistemas de recepción y emisión múltiple) Estos sistemas disponen de varias antenas (no siempre visibles externamente) que permiten emitir y recibir desde diversos puntos, direcciones,.. lo cual, permite al sistema ser más robusto ante interferencias, rebotes de señal y alcanzar mayores distancias y velocidades. Es necesario tener en cuenta a que la identificación de elementos metálicos no es siempre tan simple como suele pensarse. Objetos como los cristales tintados (cuyo tinte se suele realizar con plomo, y no es necesario que el cristal sea totalmente oscuro, si no que una ligera coloración no siempre apreciable sin una observación detenida puede ser suficiente para bloquear una gran parte de la señal), muros prefabricados con aislante interior o placas metálicas ocultas, ladrillos confeccionados con barro con un alto contenido metálico, etc. pueden afectar notablemente la propagación de la señal o incluso bloquearla totalmente. Al respecto de las interferencias, y con carácter general, no propietario en exclusiva de ninguna de las dos bandas, es una fuente muy importante cualquier elemento que pueda provocar una chispa eléctrica, la cual producirá una interferencia de amplio espectro. Así pues motores eléctricos, como los presentes en frigoríficos, fotocopiadoras, aires acondicionados, etc. son en ocasiones fuentes de interferencia, sobre todo en el arranque de estos, máxime si son de baja calidad o están deteriorados con el uso. Así mismo elementos de iluminación como los tubos fluorescentes en mal estado pueden provocar interferencias apreciables. 3 Tecnologías3.1 802.11bLa norma 802.11b surgió como una evolución de la 802.11 en el año 1999, con el objetivo de solventar el problema de velocidad que esta presentaba. Con la adopción de esta nueva norma se popularizaron las redes Wi-Fi pues la velocidad que ofrece, aun estando lejos de la red cableada, la hace apta para los usos más comunes. Añadido a esto, los costes de fabricación disminuyeron y los equipos fueron asequibles para un gran número de empresas y particulares. Trabaja en la banda de 2,4 GHz y permite obtener una velocidad de hasta 11 Mb/s. La modulación y el sistema de transmisión de la señal, hace que los canales tengan forma de campana, con mayor amplitud de señal en la frecuencia central. Esto provoca que la señal que ”invade” los otros canales tenga menor frecuencia y la interferencia sea menor que en otras normas como la 802.11g, aunque no por ello la hace carecer de importancia. 3.2 802.11aLa norma 802.11a define el funcionamiento de equipos en la banda de 5 GHz, permitiendo velocidades de hasta 54 Mb/s. Fue aprobada el mismo año que la norma 802.11b pero, a pesar de las ventajas de la tecnología debido a la banda de frecuencia utilizada, su adopción ha sido muy lenta, y en nuestro país casi nula debido a varios problemas. En un principio la calidad de lo sistemas 802.11a presentó problemas en cuanto a fiabilidad, lo cual junto a un precio elevado debido al mayor coste y dificultad de fabricación de los elementos necesarios para construir estos sistemas, retrasó su implantación en un primer momento. Particularmente en Europa se produjo un retraso en la adopción de esta norma por cuestiones de regulación del espectro electromagnético que en la fecha de la creación de la norma estaba asignado a usos privados. No fue hasta el año 2002 cuando la banda de 5 GHz se liberalizó permitiendo el uso de estos equipos en Europa. Para esas fechas la base implantada de sistemas 802.11b hacía costosa la migración hacia 802.11a, ya que ambas normas no son compatibles. El mayor coste inicial de estas soluciones, el retraso en su salida al mercado, la menor disponibilidad de sistemas compatibles con esta norma y el coste de reciclado de equipos a la nueva norma fueron elementos disuasorios para la adopción de la nueva norma. A esto se añadió el echo de que en un año estaría ratificada la nueva norma 802.11g, compatible con la base instalada y que proporciona la misma velocidad que la 802.11a. 3.3 802.11gLa norma 802.11g fue aprobada en el año 2003. Se trata de una tecnología que opera en la banda de los 2,4 GHz y proporciona una velocidad máxima de 54 Mb/s. La principal ventaja de esta tecnología reside en la mayor velocidad aportada y la compatibilidad con la base de equipos Wi-Fi conformes a la norma 802.11b ya instalados. Los equipos 802.11g comparten los mismos canales que la norma 802.11b (cosa por otro lado necesaria si queremos aportar compatibilidad entre ambas tecnologías). Sin embargo, de forma nativa, la modulación utilizada es diferente, lo que le proporciona la mayor velocidad de transmisión. A causa de esta nueva modulación también se observa que la ocupación del espectro dentro del canal, en vez de tener forma de campana como en la norma 802.11b, tiene forma rectangular, lo cual implica que los bordes del canal, aquellos que solapan con los canales adyacentes, ya no tiene una menor potencia que el centro de éste, lo que tiene como consecuencia que interfieran con mayor intensidad con los otros canales puesto que las potencias son comparables y es mas difícil discernir ambas señales. Los puntos de acceso 802.11g permiten la operación un modo compatible 802.11b o en modo que solo acepten clientes 802.11g. En caso de que funcionen en modo compatible, aceptaran los dos tipos de modulaciones, tanto la correspondiente a 802.11b como la correspondiente a 802.11g. Así mismo se activará obligatoriamente el protocolo RTS/CTS. Cuando en una celda existan clientes 802.11b, antes de emitir los clientes deberán utilizar el protocolo RTS/CTS utilizando la modulación correspondiente a 802.11b para asegurar que todos los clientes de ambas normas pueden recibir la información. Así pues, al querer emitir un cliente 802.11g se enviarán las tramas RTS/CTS en las que se marcará el tiempo que durará dicha transmisión. Los clientes 802.11b deberán esperar hasta transcurrido ese intervalo para poder emitir. Una vez que el cliente 802.11g ha reservado el canal, transmitirá la información utilizando su modulación nativa a la velocidad que le permite 802.11g y su situación actual. Los clientes 802.11b, durante la transmisión, no serán capaces de interpretar la información, interpretándola como ruido de fondo. Pero puesto que por las tramas RTS/CTS saben que han de esperar, y no tiene influencia que no puedan interpretar la transmisión pues no es información dirigida a ellos (pues en otro caso se habría utilizado su modulación para enviarles la información) se garantiza la convivencia de ambas normas. Debido a la negociación que debe utilizarse, con tiempos mas lentos y compatible con 802.11b, la velocidad ofrecida por la celda decrece notablemente al trabajar en modo dual b/g y puesto que habrá intervalos de tiempo en los que se emitirá a 11 Mb/s para ofrecer compatibilidad para los clientes 802.11b la velocidad global para los clientes 802.11g se reducirá muy significativamente en cuanto haya trafico 802.11b en la celda. Es de mencionar, que si la red Wi-Fi se compone de varias celdas, auque tan solo una de ellas tenga clientes 802.11b, todos los puntos de acceso funcionarán en modo compatible b/g pues los clientes pueden tener movilidad y pasar de la zona de cobertura de un punto de acceso al adyacente, lo cual provocara un menor rendimiento en toda la red, no solo en la celda con clientes 802.11b. Es por estas razones por lo que resulta recomendable evitar en la medida de lo posible el modo de compatibilidad b/g y fijar el modo puro 802.11g si en la red no se ha de dar servicio a clientes 802.11b. 3.4 802.11nLa norma 802.11n fue publicada en el año 2007, con el objeto de dar mayor velocidad que las existentes hasta el momento, pasando de 54 Mb/s a unos teóricos 600 Mb/s. Sin embargo a día de hoy lo normal son 300 Mb/s, existiendo algún sistema que llega hasta los 450 Mb/s, no siendo lo habitual. Pero la norma contempla la posibilidad y los medios para alcanzar velocidades mayores, con lo que es de esperar que en los equipos disponibles vaya acercándose a los 600 Mb/s en un futuro cercano. Se obliga a tener dispersión espacia, utilizando tecnología MIMO, lo cual, junto con el resto de características de esta norma, permite un mayor alcance que el las normas anteriores. No resulta posible calcular dicho alcance de forma general, pues depende fuertemente de la configuración de las radios y antenas de los equipos, y existen diseños muy diversos. La norma 802.11n ofrece la posibilidad de funcionar en ambas bandas, tanto en 2,4 GHz como en 5 GHz. Una de las grandes ventajas de la nueva norma es la compatibilidad con las normas anteriores lo cual posibilita la integración de sistemas nuevos en redes ya existentes y una migración sencilla y económica. Actualmente hay una gran oferta de sistemas con posibilidades de conexión Wi-Fi 802.11n en 2,4 GHz, pero pocos que soporten la banda de 5 GHz o proporcione conexión dual. El menor coste y la compatibilidad con los sistemas Wi-Fi anteriores que funcionan en la banda de 2,4 GHz causo esta tendencia del mercado. Para conseguir esta mayor velocidad, los equipos 802.11n siguen dos estrategias: un mayor ancho de banda del canal y uso de la tecnología MIMO con división por multiplexación espacial (SDM). El ancho de banda que ocupa un canal en 802.11n pasa de los 20 MHz que ocupaban los sistemas anteriores, a 40 MHz. Esto no es un problema en 5GHz, donde los canales no se solapaban, pero en 2,4 GHz, un canal de 40 MHz ocupa el 82% de la banda disponible. Esto implica que no podrán coexistir dos canales 802.11n sin solapamiento en 2,4 GHz y que este solapamiento abarcará ademas la mayoría del canal. Incluso con sistemas Wi-Fi de otras normas o equipos no Wi-Fi que emitan en esta frecuencia (como Bluetooth, teléfonos inalámbricos,…) el espectro libre será mínimo, quedando casi asegurada la interferencia con el resto de sistemas. La compatibilidad con sistemas 802.11a/b/g puede ser realizada en dos modos: encapsulando la transmisión en los canales de 20 MHz o utilizando un canal de 40 MHz. Encapsulando la transmisión en los canales de 20 Hz, la transmisión será siempre encapsulada en 802.11a u 802.11g. Esta encapsulación propiciará que los propios medios de protección de las normas a/g sean suficientes para la protección de los dos canales que utilizará el terminal 802.11n, pero en presencia de un terminal 802.11b será necesaria la utilización del protocolo RTS/CTS, al igual que debían hacerlo los equipos 802.11g, para asegurar una transmisión ordenada. Si se opta por la emisión en un canal de 40 MHz en entornos mixtos, será imprescindible que los clientes 802.11n utilicen el protocolo RTS/CTS en cada uno de los dos canales de 20 MHz, correspondientes a las normas 802.11b/g, que conforman en canal de 40 MHz, para asegurarse no entrara en conflicto la transmisión en ninguno de los dos subcanales con otros sistemas que pudieran estar transmitiendo. Al igual que ocurría con el modo de compatibilidad que presentaba la norma 802.11g para la norma 802.11b, aquí también se experimentará una reducción significativa de velocidad al mezclar distintas normas en una red. La otra estrategia que sigue la norma 802.11n para conseguir mayor velocidad es el uso de tecnología MIMO con dispersión por separación espacial (SDM). Los equipos 802.11n disponen siempre de varias antenas para transmitir y otras tantas para recibir. Lo sistemas son capaces de emitir un flujo de datos diferente por cada antena, permitiendo así una mayor velocidad de global transmisión. Esta tecnología precisa de circuitería específica por cada antena, en concreto un emisor de radio y un conversión analógico/digital independiente, lo que redunda en un mayor coste y complejidad técnica. Esta es la razón de que existan varias configuraciones de antenas, dependiendo del equipo seleccionado. El número de flujos de datos simultáneos que se pueden emitir está limitado por el número de antenas disponibles en ambos lados, así pues si el equipo transmisor dispone de tres antenas emisoras pero el destino solo de dos receptoras, la comunicación solo podrá efectuarse con dos flujos de datos independientes. Las radios limitan el número de antenas y flujos de datos que pueden utilizarse, debido a un diseño seleccionado en base a la dificultad técnica y el coste. El tipo de radio que incorpora un equipo se designa con la siguiente nomenclatura “a x b : c”. “a” indica el número máximo de antenas o canales de radiofrecuencia de emisión que la radio puede utilizar, “b” expresa el número máximo de antenas o canales de radiofrecuencia de recepción del que puede hacer uso el sistema y “c” indica el número máximo de flujos de datos que pueden ser usados. Así pues un sistema 3x2:2 podrá utilizar hasta tres antenas de transmisión, dos de recepción y dos flujos de datos independientes. Es importante interpretar éste dato puesto que las antenas no suelen ser visibles, y desde luego, los flujos de datos no lo son, y es importante para evaluar el rendimiento del sistema, sobre todo para no invertir en puntos de acceso muy capaces si los clientes no lo serán, o viceversa. Actualmente las configuraciones mas habituales son 2x2:2, 2x3:2, 3x3:2 siendo el máximo previsto por la norma 4x4:4. Lo cual justifica la discrepancia entre la velocidad de los sistemas actuales (300 Mb/s) y la máxima prevista por la norma (600 Mb/s). Así mismo se ve que los sistemas que empiezan a salir con configuraciones 3x3:3, que deberían ser capaces de alcanzar 450 Mb/s, pero solo serán útiles si los clientes poseen la misma configuración, cosa que no es habitual de momento. Se llama la atención al lector sobre el hecho de que es habitual sistemas con más antenas que flujos de datos. Esta configuración les permite tener una mayor diversidad espacial, no para alcanzar una mayor velocidad de comunicación, si no para obtener una mejor resistencia ante interferencias y proporcionar mayor alcance. Con el objeto de incrementar la velocidad de transmisión, los sistemas 802.11n incluyen un concepto nuevo, no existente en las anteriores normas: la supertrama. Los equipos 802.11n no transmiten la información tal cual se les requiere, si no que la encapsulan en una trama mayor con el fin de optimizar la utilización de la radio. Esta característica, aun siendo teóricamente deseable, presenta diversos problemas en los equipos, pues han de almacenar la información que les llega para ser transmitida hasta que conforman la supertrama. Así mismo han de encajar los paquetes de información de manera eficiente en la supertrama y en la recepción, deben desempaquetarla. Esto supone una mayor demanda de los equipos 802.11n y una mayor potencia de proceso de la necesaria en generaciones anteriores, y es, así mismo, fuente de problemas en algunas implementaciones, no siendo extraño observar grandes diferencias en la velocidad de transmisión dependiendo del tipo de información transmitida, sobre todo para ciertos tamaños de paquetes o mezcla de tamaños, debido al proceso de empaquetado y desempaquetado y los algoritmos de optimización de este proceso. 4 Sistemas de gestión Wi-Fi centralizadosOriginalmente los sistemas Wi-Fi eran autónomos. Cada punto de acceso tenía toda la capacidad para crear la celda y gestionar los clientes a ella asociados y las comunicaciones entre estos, y entre ellos y la red cableada. Cuando las redes Wi-Fi pasaron de ser una solución puntual para solventar problemas concretos, y siempre de tamaño reducido, a grandes instalaciones complejas que soportan gran parte de las comunicaciones de una empresa, o incluso en algunos casos son en si mismo la fuente de ingresos (como puede ser el caso de los hot-spots en aeropuertos), se vio la necesidad de disponer de sistemas de gestión centralizados. La primera aparición de estos sistemas vino dado por el alto precio de los puntos de acceso en sus primeros tiempos. Para abaratar las grandes instalaciones, se tomó la decisión de hacer puntos de accesos menos inteligentes, y se transfirió esa inteligencia a un sistema centralizado. Es cierto que este sistema de control suele tener un coste elevado, pero si la instalación es grande, la reducción en el precio de cada punto de acceso lo compensa y el precio global es mas reducido que en el caso de una instalación realizada con puntos de acceso autónomos. Con el tiempo, las redes Wi-Fi fueron soportando más servicios y se demando cada vez mas de ella, teniendo que aportar más opciones de configuración y funcionalidades que las hicieran aptas para las aplicaciones y servicios que de ellas hicieran uso. En instalaciones con un elevado número de puntos de acceso, la configuración manual de cada uno de ellos y su mantenimiento, así como la detección y corrección de errores se tornó compleja y el coste en tiempo y personal demasiado elevado. Los sistemas de gestión centralizados tienen como objetivo paliar estos problemas y ofrecer funcionalidades añadidas. Es cierto que no se pueden enumerar las funcionalidades de estos sistemas, puesto que no existe un modelo y cada fabricante toma la aproximación que le parece más conveniente, pero suele tener algunas características y funcionalidades básicas comunes. Habitualmente el controlador se vende como un sistema independiente cerrado, pero internamente es siempre un ordenador con un software asociado y preinstalado, al cual el usuario no tiene acceso más que por la consola de configuración. En cualquier caso, los controladores se conectarán en la red Ethernet del cliente, desde la que detectarán a los puntos de acceso con los que sea compatible. Una vez detectados, realizará una configuración previa de estos y permitirá su gestión centralizada desde un solo punto, el controlador. Dependiendo el fabricante, se implementarán distintas medidas para elegir que puntos de acceso han de ser gestionado, ya sea mediante una precofiguración de la dirección IP en el punto de acceso, o mediante algún tipo de filtrado y/o clave en el controlador. Una vez añadido el punto de acceso se le cargara automáticamente una configuración base, lo cual reduce los tiempos de instalación y minimiza los errores de configuración. El objetivo general de esta fase es que la instalación de nuevos sistemas se simplifique. Una vez realizado el despliegue inicial el controlador permitirá desde una sola consola configurar los distintos puntos de acceso, individualmente, por grupos o globalmente así como recibir alarmas asociadas al funcionamiento de ellos. Como se ha comentado, la funcionalidad depende de cada fabricante, pero estas son algunas de las ofrecidas:

En la siguiente imagen se muestra como con tres puntos de acceso se puede deducir la distancia a ellos de un terminal, basándose en la potencia recibida, y con estas tres distancias, obtener la localización del cliente Wi-Fi.

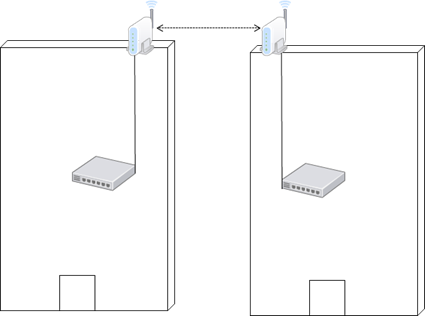

5 Enlaces inalámbricos (WDS)Una funcionalidad ofrecida por muchos puntos de acceso es la posibilidad de realizar enlaces inalámbricos entre dos de ellos, con el objetivo principal de unir dos redes, y en algunos casos, para proporcionar cobertura inalámbrica en puntos donde no hay acceso a la red cableada, sin renunciar a la comunicación con esta. El sistema para realizar este tipo de enlace no esta estandarizado, existiendo multitud de soluciones propietarias, cada una con sus virtudes y defectos, aunque los principios básicos de funcionamiento son similares. Sin embargo hay un método de comunicación que aun no teniendo certificación de la Wi-Fi Alliance ni de ningún otro organismo es ampliamente utilizado. Hay que tener en cuenta sin embargo, que al no tener ninguna certificación, los sistemas que utilicen este protocolo no serán en la mayoría de los casos compatibles entre si, y en muchos ni tan siquiera entre distintos modelos de pertenecientes al mismo fabricante. El método referido es el Wireless Distribution System (WDS). La meta de este protocolo es permitir la interconexión de los puntos de acceso de una red 802.11 sin necesidad de estar conectados a una red cableada, preservando la dirección MAC (equivalente a la dirección Ethernet cuando la trama llegue a la red cableada) de cada uno de los clientes. La conservación de la dirección MAC de los clientes provoca que el enlace WDS sea percibido por el resto de los equipos como un cable que no influye en la comunicación. En una red WDS un punto de acceso puede ser configurado de manera que asuma uno de los siguientes tres roles:

Cuando un punto de acceso, funcionando en modo WDS con enlace a otros, da cobertura a clientes locales, hay que tener en cuenta que el ancho de banda disponible para los clientes locales pertenecientes a su celda se reduce a la mitad, pues toda transmisión proveniente del cliente ha de ser repetida por el enlace WDS, y viceversa, toda comunicación que provenga del resto de la red por el enlace WDS ha de ser repetida en la celda local, con lo que cada trama será transmitida por duplicado. Así pues, si la estación base puede ofrecer a sus clientes 54 Mb/s, la estación base repetidora que se conecte a ella podrá ofrecer tan solo 27 Mb/s, y a cada salto la velocidad ofrecida se seguirá reduciendo a la mitad. Dependiendo del fabricante, los puntos de acceso pueden tener la posibilidad de crear más de un enlace WDS, lo que les permitirá crear redes en malla (“mesh”). Así mismo hay productos, que para evitar la perdida de velocidad con cada salto, dotan a sus productos con dos módulos de radio, pudiendo así utilizar uno para crear el enlace con otras estaciones base y el segundo para dar cobertura local. Como se puede ver por lo expuesto hasta ahora, las redes WDS pueden ser utilizadas en dos modos:

Los enlaces WDS usualmente presentan limitaciones en el campo de la seguridad. No están disponibles todas las opciones de encriptación y en los equipos mas económicos (aunque sorprendentemente no solamente en ellos) solo los métodos mas básicos de encriptación y autentificación están disponibles. Esto es peligroso, puesto que lo normal es que estos enlaces se efectúen a través de lugares públicos y espacios abiertos, porque son justamente estos espacios los que impiden el acceso a la red cableada y hace necesario un enlace inalámbrico. Así pues, si el equipo no implementa mecanismos fiables de encriptación, expondrá un punto de infusión y ataque a la red. Es habitual que los equipos que soporten esta funcionalidad tengan la opción de conectar una antena exterior. En el caso de enlaces punto a punto no es deseable que la señal se irradie en todas las direcciones, si no que es preferible que se concentre en una dirección concreta, con lo que se gana seguridad y sobre todo alcance. Es por tanto posible, en muchos equipos, conectar antenas externas direccionales, tipo yagi o parabólicas, que proporcionan alcances mayores de los obtenidos con antenas convencionales, siendo en algunos casos de varios kilómetros. 6 Video, Voz y DatosLa mayor capacidad de las redes de datos y de los equipos, tanto ordenadores como sistemas especializados, así como su menor coste, ha hecho que se popularice el uso de tráfico multimedia. Actualmente es normal que las diferentes operadoras de telefonía ofrezcan lo que se suele llamar “triple play”, que designa el servicio de datos, voz y audio sobre redes IP. Este servicio se ha popularizado en las redes privadas, siendo habitual que conviva la voz sobre IP (VoIP) con los datos en la misma red, debido a las ventajas en funcionalidad y reducción de costes que ofrece sobre la telefonía convencional. Recientemente el servicio de video se ha desarrollado notablemente, tanto a nivel particular, como empresarial, y muy notablemente en centros de enseñanza donde aporta nuevas posibilidades docentes. La transmisión de video y voz a través de una red IP convencional presenta una serie de retos, debido a las necesidades específicas de este tipo de tráfico, que fuerzan a que los elementos de red deban poseer ciertas características necesarias para el buen funcionamiento del servicio. Si esto es cierto en redes cableadas, lo es mucho mas en redes Wi-Fi puesto que en este ultimo caso, el medio es compartido, no solo con interferencias y elementos externos, si no con el resto de los clientes. A continuación se expondrán las distintas necesidades de cada uno de los tres tipos de tráfico, con el objeto de que el lector comprenda la problemática asociada y sea capaz de evaluar las estrategias que existen para intentar solventar o minimizar los problemas derivados de las peculiaridades de este tráfico. 6.1 Necesidades del tráfico de datosLa transmisión de datos, como pueden ser ficheros de un servidor, correo electrónico o páginas WEB, es un tráfico poco exigente. El servicio demanda la mayor velocidad de transmisión y la menor pérdida de paquetes posible. Es cierto que en las redes Wi-Fi estos dos parámetros no son tan fáciles de optimizar como en las redes cableadas, pues las velocidades de transmisión son menores y siempre existe alguna interferencia externa, o simple colisión entre clientes (que como se vio, es posible que ocurra a pesar de las protecciones implementadas), lo que provocará alguna perdida. El usuario lo que apreciará es la velocidad de acceso a los datos, pero a no ser que ésta se reduzca por debajo de un cierto umbral que la haga inaceptable, y ese umbral dependerá de la aplicación, no habrá una mayor exigencia. 6.2 Necesidades del tráfico de videoEl tráfico de video es más exigente. Con respecto a la transmisión de datos, este tipo de tráfico añade requerimientos extra, los cuales están motivados porque el video ha de ser mostrado en el instante que corresponde. El hecho de que los datos lleguen mas despacio, en una pagina web influye en que tarde menos o mas en bajar, pero los fotogramas del video se han de mostrar cuando corresponden, o el video no será visionado de forma correcta, apreciándose artefactos, sonido deficiente, aceleraciones del vídeo, pausas, etc. En general, a parte de una velocidad de transmisión mínima para poder transmitir en video con fiabilidad, y una falta de perdida de paquetes, hará falta un cumplimiento de otros parámetros como el jitter, latencia, duplicación y reordenación de paquetes y emisión en ráfagas. Aunque no son conceptos propios de las redes Wi-Fi si no de cualquier comunicación en general, son ampliados por este tipo de redes y es necesario explicarlos para entender apartados posteriores. El video, dependiendo de la codificación y la calidad de la imagen, demandará un ancho de banda mínimo, que deberá ser soportado por la red Wi-Fi para proporcionar un buen servicio. En caso de que la red no sea capaz de proporcionar esta velocidad, se perderá información al no poder ser enviada por la red, provocando perdida de paquetes. La pérdida de paquetes, ya sea por causa de un tráfico excesivo para la red, por interferencias o cualquier otra causa, provocará video de calidad deficiente, mostrándose los típicos cuadros, cortes de sonido o chasquidos. Si no existen mecanismos de corrección de errores, y estos solo suelen implementarse en proveedores de televisión dada su complejidad y coste, cada paquete perdido se traducirá en un error apreciable por el usuario. El jitter es la variación en el retardo o latencia de los paquetes. Si los paquetes no llegan con la misma cadencia, el sistema receptor ha de ser capaz de ofrecer un buffer (termino para designar capacidad de almacenaje de paquetes) para no perderlos cuando lleguen mas juntos de lo debido o de tener almacenados los suficientes paquetes para soportar una espera mayor en la recepción del siguiente paquete, cuando este demore su llegada más de lo esperado. De no ser así se producirán errores análogos a los ocurridos por las perdidas de paquetes en el caso de que se reciban mas paquetes de los que se pueden almacenar hasta que llegue el momento de mostrarlos, o congelaciones de imagen en el caso de que el retraso en la llegada de información no permita al sistema actualizar la imagen. La latencia mide el tiempo que tarda un paquete en viajar desde el origen del video hasta el destino. No es muy importante en video a no ser que se emita un evento en directo y la simultaneidad sea importante, como es el caso de eventos deportivos. Pero en la mayoría de los casos no es un parámetro crítico para el video. La duplicación y reordenación de paquetes es un fenómeno que sucede en las redes más habitualmente de lo que se cree, y en video es importante, pues si se produce y no se detecta, gracias a la inclusión de algún protocolo junto con los algoritmos pertinentes en los clientes, dará como resultado que se muestre información que no corresponde con el instante y fotograma en curso, con la consecuente degradación en la calidad de la imagen y sonido. Las ráfagas son algo habitual en sistemas de comunicación que adolecen de congestión. Sucede cuando el equipo de red, en nuestro caso un punto de acceso o un cliente Wi-Fi, no puede enviar información la almacena temporalmente y la enviará de golpe cuando le sea posible, si no media ningún mecanismo de control. Esto provoca que el cliente reciba en una ráfaga mas información de la que debería, por lo que si los buffers no son del tamaño adecuado, tendremos el mismo efecto que en el jitter (De echo las ráfagas son una forma de jitter extremo, pues los paquetes no llegan con una cadencia constante, si no agrupados tras un periodo de parada o precediéndolo) En la emisión de vídeo, cuando la difusión de este se realiza a varios clientes simultáneamente, es habitual un tipo de transmisión que recibe el nombre de multicast. En este tipo de emisión se transmite un paquete con una dirección especial que capturarán los clientes interesados en recibirlo, para lo cual se subscribirán a la recepción de dicho flujo de datos. Este método permite que solo se envíe un paquete, independientemente del número de clientes que deseen recibirlo, con el consiguiente ahorro de ancho de banda. Sin embargo, como contrapartida exige más a los elementos de red, que han de ser capaces de gestionar dicho tráfico de forma correcta, lo cual les demanda mayor capacidad de proceso y memoria así como implementar los algoritmos y protocolos adecuados. Es interesante aquí llamar la atención sobre el hecho de que el video Flash (el utilizado por portales como youtube) tiene unas necesidades diferentes. Su método de transmisión y tratamiento difiere, pues es transmitido como datos sobre una conexión TCP con todo lo que ello implica, y no como video y es precisamente esa diferente filosofía de transmisión lo que lo ha popularizado en Internet al hacerlo inmune a los parámetros antes mencionado, pero no apto para transmisiones simultaneas a diversos clientes, ni emisiones en tiempo real. 6.3 Necesidades del tráfico de vozLas necesidades del tráfico de voz, en este caso voz sobre IP (VoIP), son análogas a la del video, puesto que se trata de un servicio que no permite perdida de información y que precisa de una temporización muy estricta. Sin embargo, existen dos diferencias con respecto al servicio de video. La primera es que aunque es necesario que se garantice un acho de banda y que este dependerá del sistema de codificación de la voz que utilice el sistema, esta velocidad de transmisión será mucho menor que en caso del video. La segunda diferencia a tener en cuenta es que la latencia es un parámetro importante para la voz. Si esta es alta, la red no será apta para conversaciones de voz, pues un retraso mínimo es percibido muy negativamente por los usuarios. Para ilustrar al lector, el efecto es el apreciado en las comunicaciones telefónicas por satélite, y la causa, la misma. 7 Wi-Fi y QoSLas redes Wi-Fi, al ser redes inalámbricas de canal compartido entre todos los clientes de una celda, implementan controles de acceso al medio, necesarios para evitar colisiones e interferencias en caso de que más de un usuario emita al mismo tiempo, como ya se pudo ver en apartados anteriores. Estos mecanismos son el CSMA/CA y el RTS/CTS que se engloban dentro de lo que se denomina DCF (Distributed Coordination Function). Sin embargo este sistema de control de acceso al medio no previene que un cliente pueda monopolizar el medio en mucha mayor medida que el resto, afectando al servicio en la celda e imposibilitando su utilización con algunas aplicaciones sensibles al retardo y el jitter. Una primera solución a este problema viene de la mano de un sistema de control que recibe el nombre de PCF (Point Coordination Function). Dicho mecanismo solo es funcional en redes de tipo infraestructura, nunca en redes ad-hoc, pues será el punto de acceso el encargado de realizar dicho control. Cuando se activa el PCF, el tiempo que existe entre dos paquetes “beacon” (aquellos que usa el punto de acceso para anunciar su presencia y las características de la red) enviados por el punto de acceso, se divide en dos periodos CFP (Content Free Period) y CP (Content Period). Durante el periodo CFP el funcionamiento de la red es como se ha explicado hasta el momento a lo largo del documento, mientras que durante el CP, los clientes no emitirán por iniciativa propia, si no que el punto de acceso le enviará un paquete a cada usuario por turnos, dándoles la oportunidad de emitir. El cliente aprovechara la oportunidad para emitir o, si no tiene datos para enviar, responderá con un paquete indicándolo. Con este método se permite evitar el monopolio de un cliente, permitiendo a todos la emisión de datos con una frecuencia aceptable. Sin embargo, este sistema no es capaz de diferenciar los tipos de tráfico, solo diferencia a los clientes, y tratará igual tanto a un cliente que deba transmitir video, como al que espere emitir datos o voz. Añadido a esta limitación, existen muy pocos sistemas en el mercado que implementen este método de control. Las necesidades de los distintos tráficos, expuestas en el apartado anterior, hacen necesario que este sea gestionado de manera eficiente para que los servicios puedan ser ofrecidos con la calidad debida. Puesto que cada servicio, cada tipo de tráfico, tiene unas necesidades diferentes, es preciso diferenciarlo y aplicarle un tratamiento individual acorde a sus requerimientos. Este proceso recibe el nombre de calidad de servicio y se referencia por las siglas QoS (Quality of Service). La aplicación de políticas de QoS no solo proporciona la posibilidad de ofrecer datos, voz y videos con calidad, si no que aporta herramientas para priorizar tráficos, ya sea por la naturaleza de éste (priorizar web, sobre el correo, y todas sobre las transferencias de ficheros P2P), o por el origen (el tráfico de la dirección de un centro escolar podrá ser priorizado sobre el de los alumnos). No es suficiente con disponer de ancho de banda suficiente. Un sistema que deba transmitir datos sensibles, como voz o video, debe de implementar necesariamente QoS. La razón es simple, si durante una transferencia de voz o video, se produce una descarga de datos, esta podría ocupar todo el ancho de banda disponible. De hecho, la misma naturaleza de la transferencia de datos suele hacer deseable que así sea, pues la descarga llevará menos tiempo. La red debería sacrificar paquetes de datos en favor de los de voz o video, pues los primeros tienen mecanismos de recuperación y la única consecuencia será una ralentización del servicio y no interrupción de éste, como pasaría si el sacrificio lo realizara el tráfico de voz o video. Sin embargo el problema no surge solo en ese caso, pues aunque la descarga de datos no demande la velocidad máxima de transferencia, emitirá tráfico, y el dispositivo de red, en nuestro caso el punto de acceso o el controlador de la red Wi-Fi, deberá tener mecanismos para decir que paquetes ha de emitir antes y/o con una cadencia fija, minimizando las perdidas, la latencia, el jitter, las ráfagas, etc. Para conseguir este objetivo y minimizar los problemas en la transmisión de contenido multimedia, existieron protocolos propietarios, pero en un entorno como el de las redes Wi-Fi, donde es posible tener control sobre los puntos de acceso pero no sobre los clientes, donde suelen convivir distintos dispositivos y de distintos fabricantes, no resultaba funcional ni se obtenían los resultados deseados. Fue con la llegada del protocolo 802.11e y su respaldo por parte de la Wi-Fi Alliance con su certificación Wireless Multimedia Extension (WME), más conocida como Wi-Fi MultiMedia (WMM), cuando la QoS llego al mundo Wi-Fi. 7.1 802.11e (WMM)Por lo expuesto en el punto anterior, surgió la necesidad de tener algún mecanismo, no solo para que todos los clientes pudieran transmitir sus datos eficientemente, si no también para priorizar la transmisión de los datos sensibles, razón por la cual se desarrolló la norma 802.11e. La norma 802.11e clasifica el tráfico en cinco categorías, dependiendo las necesidades y características del tráfico. Estas categorías ordenadas de la más prioritaria a menos prioritaria son: